什麼是可抓取性和可索引性:它們如何影響SEO?

告訴我,當您考慮對網站進行排名時,您首先想到的是什麼?

內容?或者可能是反向連結?

我承認,兩者都是在搜索結果中定位網站的關鍵因素。但他們不是唯一的。

事實上,另外兩個因素在SEO中發揮著重要作用——可抓取性和可索引性。然而,大多數網站所有者從未聽說過它們。

同時,即使是可索引性或可抓取性的小問題也可能導致您的網站失去排名。這與您擁有哪些精彩內容或反向連結無關。

- 什麼是可抓取性和可索引性?

- 什麼影響可抓取性和可索引性?

- 如何使網站更容易抓取和索引?

- 用於管理可抓取性和可索引性的工具

什麼是可抓取性和可索引性?

為了理解這些術語,讓我們先看看搜索引擎是如何發現和索引網頁的。為了了解任何新的(或更新的)頁面,他們使用所謂的網絡爬蟲,這些機器人的目的是為了跟蹤網絡上的連結,只為了一個目標。

找到並索引新的網頁內容。

正如谷歌解釋的那樣:

“爬蟲查看網頁並跟蹤這些網頁上的連結,就像你在網絡上瀏覽內容一樣。他們從一個連結到另一個連結,並將有關這些網頁的數據帶回谷歌的服務器”。

谷歌前任馬特卡茨發布了一段有趣的視頻,詳細解釋了這個過程。你可以在下面觀看:

簡而言之,這兩個術語都與搜索引擎訪問網站上的頁面並將其編入索引以將其添加到其索引中的能力有關。

可抓取性描述了搜索引擎訪問和抓取頁面內容的能力。

如果網站沒有可抓取性問題,那麼網絡爬蟲可以通過頁面之間的連結輕鬆訪問其所有內容。

但是,斷開的連結或死胡同可能會導致可抓取性問題——搜索引擎無法訪問網站上的特定內容。

另一方面,可索引性是指搜索引擎分析頁面並將其添加到其索引的能力。

即使Google可以抓取一個網站,它也不一定能夠將其所有頁面編入索引,這通常是由於可索引性問題。

什麼影響可抓取性和可索引性?

1. 網站結構

網站的信息結構對其可抓取性起著關鍵作用。

例如,如果您的網站包含未從其他任何地方鏈接到的頁面,則網絡爬蟲可能難以訪問它們。

當然,他們仍然可以通過外部連結找到這些頁面,前提是有人在其內容中引用了它們。但總的來說,薄弱的結構可能會導致可抓取性問題。

2. 內部連結結構

網絡爬蟲通過跟踪連結在網絡上傳播,就像你在任何網站上一樣。因此,它只能找到你從其他內容中連結的頁面。

因此,一個好的內部連結結構,將使它能夠迅速到達甚至是你網站結構中的那些頁面。然而,一個糟糕的結構,可能會把它送到一個死胡同,導致網絡爬蟲錯過你的一些內容。

3. 循環的重定向

損壞的頁面重定向會讓網絡爬蟲停在原地,導致可爬行性問題。

4. 服務器錯誤

同樣,損壞的服務器重定向和許多其他與服務器有關的問題可能會阻止網絡爬蟲訪問您的所有內容。

5. 不支持的腳本和其他技術因素

可抓取性問題也可能因您在網站上使用的技術而產生。例如,由於爬蟲不能跟踪表單,在表單後面設置內容門檻會導致可爬行性問題。

各種腳本,如Javascript或Ajax,也可能阻擋網絡爬蟲的內容。

6. 阻止網絡爬蟲訪問

最後,您可以故意阻止網絡爬蟲對您網站上的頁面進行索引。

而且,這樣做有一些很好的理由。

例如,您可能已經創建了一個您想限制公眾訪問的頁面。作為防止訪問的一部分,你也應該把它從搜索引擎上屏蔽掉。

然而,也很容易錯誤地封鎖其他網頁。例如,代碼中的一個簡單錯誤,就可能封鎖網站的整個部分。

你可以在這篇文章中找到整個可爬行性問題的清單–《你的網站對爬蟲不友好的18個原因:可爬行性問題指南》。

如何使網站更容易抓取和索引?

我已經列出了一些可能導致您的網站出現可抓取性或可索引性問題的因素。因此,作為第一步,您應該確保它們不會發生。

但是,您還可以採取其他措施來確保網絡爬蟲可以輕鬆訪問您的頁面並為其編制索引。

1. 向谷歌提交站點地圖

站點地圖是一個小文件,位於您域的根文件夾中,其中包含指向您站點上每個頁面的直接鏈接,並使用 Google 控制台將它們提交給搜索引擎。

站點地圖會將您的內容告知Google,並提醒Google您對其進行的任何更新。

2. 加強內部連結

我們已經討論過互連如何影響可抓取性。因此,為了增加 Google抓取工具找到您網站上所有內容的機會,請改進頁面之間的連結以確保所有內容都相互關聯。

3.定期更新和添加新內容

內容是您網站最重要的部分。它可以幫助您吸引訪客,向他們介紹您的業務,並將他們轉化為客戶。

但是內容也可以幫助您提高網站的可抓取性。一方面,網絡爬蟲更頻繁地訪問不斷更新其內容的網站。這意味著他們會更快地抓取您的頁面並將其編入索引。

4. 避免複製任何內容

具有重複內容、具有相同或非常相似內容的頁面可能會導致排名下降。

但是重複的內容也會降低爬蟲訪問您網站的頻率。

因此,檢查並修復網站上的任何重複內容問題。

5. 加快頁面加載時間

網絡爬蟲通常只有有限的時間來爬取和索引您的網站。這稱為抓取預算。基本上,一旦時間到了,他們就會離開您的網站。

因此,您的頁面加載得越快,爬蟲在時間用完之前能夠訪問的頁面就越多。

用於管理可抓取性和可索引性的工具

如果以上所有聽起來令人生畏,請不要擔心。有一些工具可以幫助您識別和修復可抓取性和可索引性問題。

日誌文件分析器

日誌文件分析器將向您展示桌面和移動Google機器人如何抓取您的網站,以及是否有任何錯誤需要修復和抓取預算以節省。您所要做的就是上傳您網站的 access.log 文件,然後讓該工具完成它的工作。

訪問日誌是人們或機器人發送到您網站的所有請求的列表;通過對日誌文件的分析,您可以跟踪和了解爬網機器人的行為。

閱讀我們關於在何處查找訪問日誌文件的手冊。

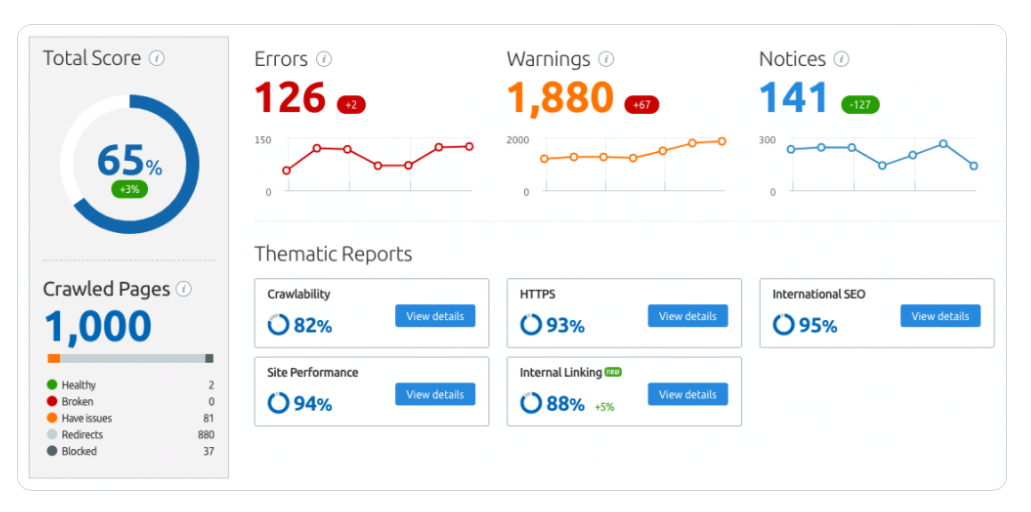

網站審核

Site Audit是SEMrush套件的一部分,用於檢查您網站的健康狀況。掃描您的網站是否存在各種錯誤和問題,包括影響網站可抓取性和可索引性的錯誤和問題。

谷歌工具

Google Search Console可幫助您在 Google中監控和維護您的網站。這是一個提交站點地圖的地方,它顯示了網絡爬蟲對您站點的覆蓋範圍。

Google PageSpeed Insights可讓您快速檢查網站的頁面加載速度。

結論

大多數網站管理員都知道,要對網站進行排名,他們至少需要強大且相關的內容和反向連結,以提高其網站的權威性。

他們不知道的是,如果搜索引擎的爬蟲無法抓取和索引他們的網站,他們的努力就會白費。

這就是為什麼除了專注於為相關關鍵字添加和優化頁面以及建立連結之外,您還應該不斷監控網絡爬蟲是否可以訪問您的網站並向搜索引擎報告他們發現的內容。